近期,MILab在弱监督目标定位方面取得最新进展,相关研究论文“Bagging Regional Classification Map for Weakly Supervised Object Localization”已被计算机视觉顶级会议ECCV 2022接收。

类别激活图 (CAM,Classification Activation Map)是一种经典的分类模型归因方法,旨在通过将分类网络中对图像级特征进行分类分类器,应用在未经过聚合前的像素级特征上,进而得到一张可以展示图像中每一位置对各类别的隶属概率的热力图。由于CAM的生成仅依赖于基于图像级标签训练的分类网络,因此这种方法几乎所有基于图像级标签的弱监督目标定位及弱监督图像分割方法使用。

然而,虽然CAM可以仅依据图像级标签训练模型并得到目标物体的粗定位结果,但方法实际上是直接将分类器当做定位器使用,而缺乏考虑二者之间的目标差异性。具体来看,用于图像分类中的分类器只需要关注到部分鉴别性特征即可完成对图像的正确分类,而用于目标定位中的定位器(分割器)需要关注非鉴别特征及局部特征才可以实现目标定位。因此,若直接将分类器用作定位器的话作用于像素级特征的话,显然分类器只能激活鉴别性区域而无法获得更为全面的激活图。

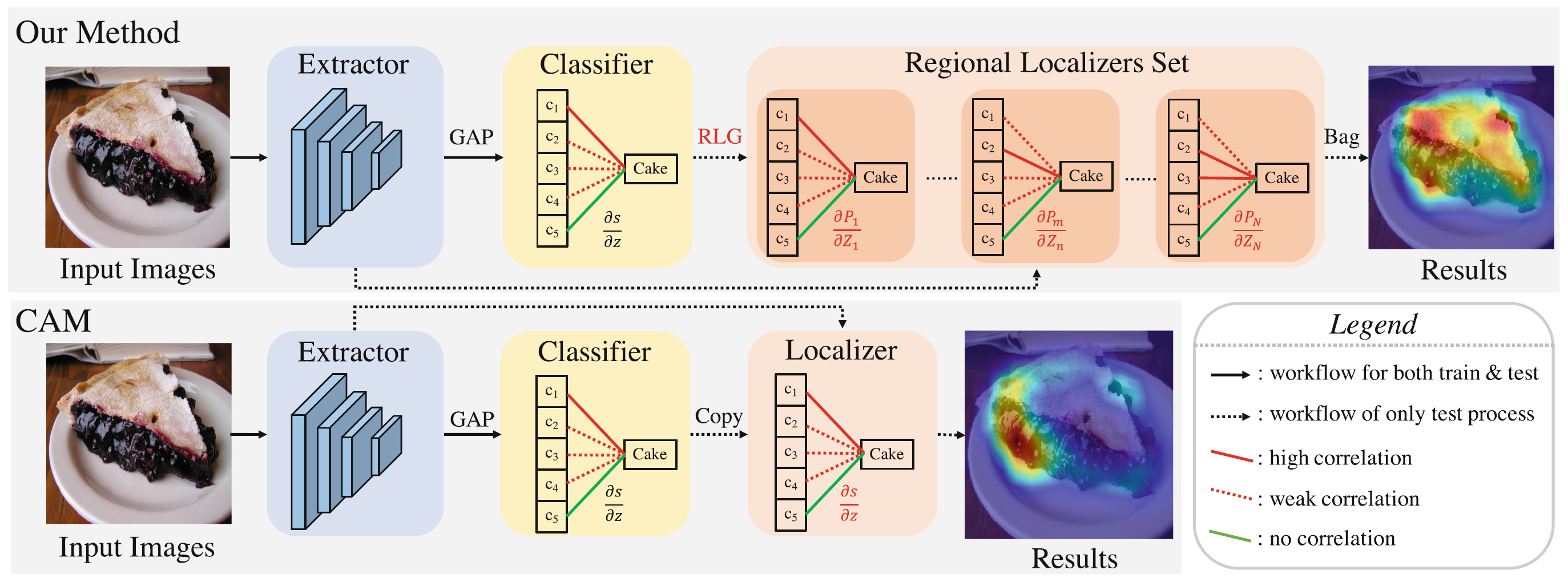

为解决这一问题,MILab提出了一种BagCAMs策略,使得可以利用一个训练好的全局分类器导出局部定位器,并以将该定位器用于像素级特征进行目标定位。如图1所示,区别CAM直接使用分类器作为定位器,本方法首先提供了一种定位器生成策略RLG,使得我们可以通过全局分类器及像素级特征,生成若干个局部定位器,并进而利用这些局部定位器的定位结果进行集成,形成最终覆盖面较广的目标定位图。

图1 BagCAMs与传统CAM的对比

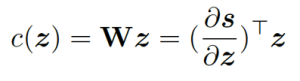

首先,对于图像级特征进行分类的分类器,我们可以间接用分类结果对全局特征的导数进行表示,即:

将此概念进行扩展,我们也可以用分类结果对局部特征的导数,表示一个可以感知到局部信息的分类器,我们称之为局部定位器。以此概念,对一张分辨率为N的特征图,我们即可导出一个包含N个局部定位器的定位器集合:

再进一步来说,对于N个分类结果,也就是一张粗定位图,我们可用其生成N*N个局部定位器,即:

再进一步来说,对于N个分类结果,也就是一张粗定位图,我们可用其生成N*N个局部定位器,即:

得到这N*N个局部定位器,我们可以将其定位结果依权重进行集成,得到最终的定位图:

得到这N*N个局部定位器,我们可以将其定位结果依权重进行集成,得到最终的定位图:

图2 BagCAMs工作流程图

图2 BagCAMs工作流程图

利用上述策略,我们可以利用不同的粗定位图生成方法(如CAM、GradCAM)以及不同的集成策略,对我们提出的BagCAMs策略进行实例化。如图2所示,我们使用了Pixel-class Sampling方法进行实现即:

将二者带入到BagCAMs定义中,我们可以得到最终的BagCAMs实现公式,以此替代CAM作为弱监督目标定位生成定位图的方法:

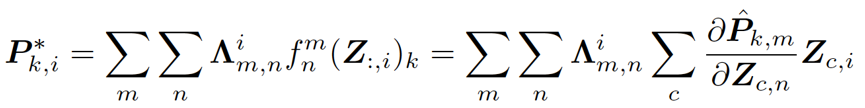

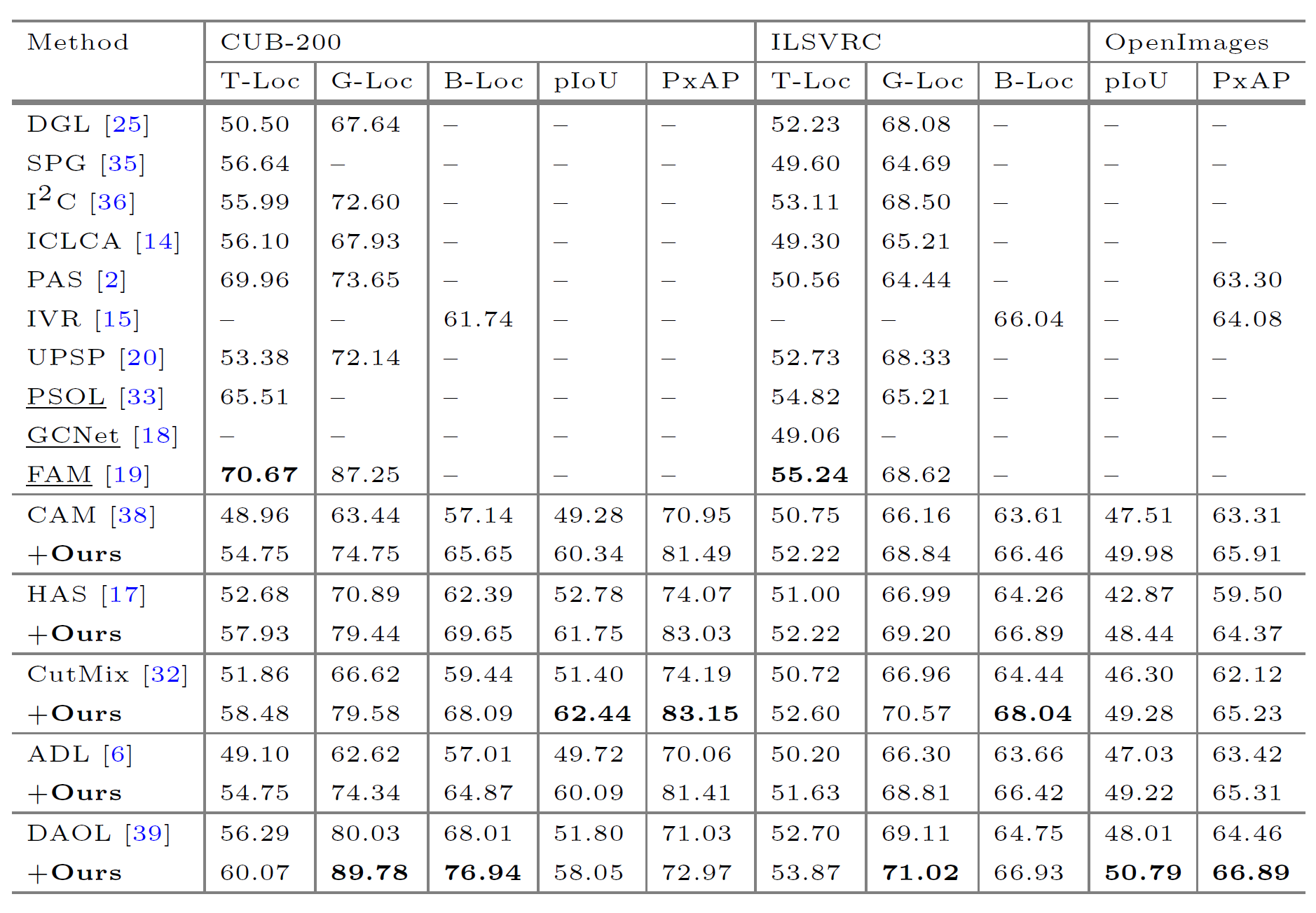

我们在三个标准弱监督定位数据集上对我们的方法进行了验证,包括CUB-200鸟类细粒度识别数据集,OpenImages分割数据集以及ImageNet目标识别定位数据集,在这些数据集上我们的模型在定位相关指标中都达到了当前最高。此外,我们也结合了多种弱监督定位方法并以BagCAM替代其中的CAM步骤,可以发现,我们的BagCAMs均可以显著提升这些方法的效果:

我们在三个标准弱监督定位数据集上对我们的方法进行了验证,包括CUB-200鸟类细粒度识别数据集,OpenImages分割数据集以及ImageNet目标识别定位数据集,在这些数据集上我们的模型在定位相关指标中都达到了当前最高。此外,我们也结合了多种弱监督定位方法并以BagCAM替代其中的CAM步骤,可以发现,我们的BagCAMs均可以显著提升这些方法的效果:

表1 BagCAMs与SOTA方法的性能对比(ResNet50为backbone)

表2 BagCAMs与SOTA方法的性能对比(InceptionV3为backbone)

同时,相比于其他方法,我们提出的BagCAMs也可以使用非最后一层特征进行定位,以获得更好的细节特征。

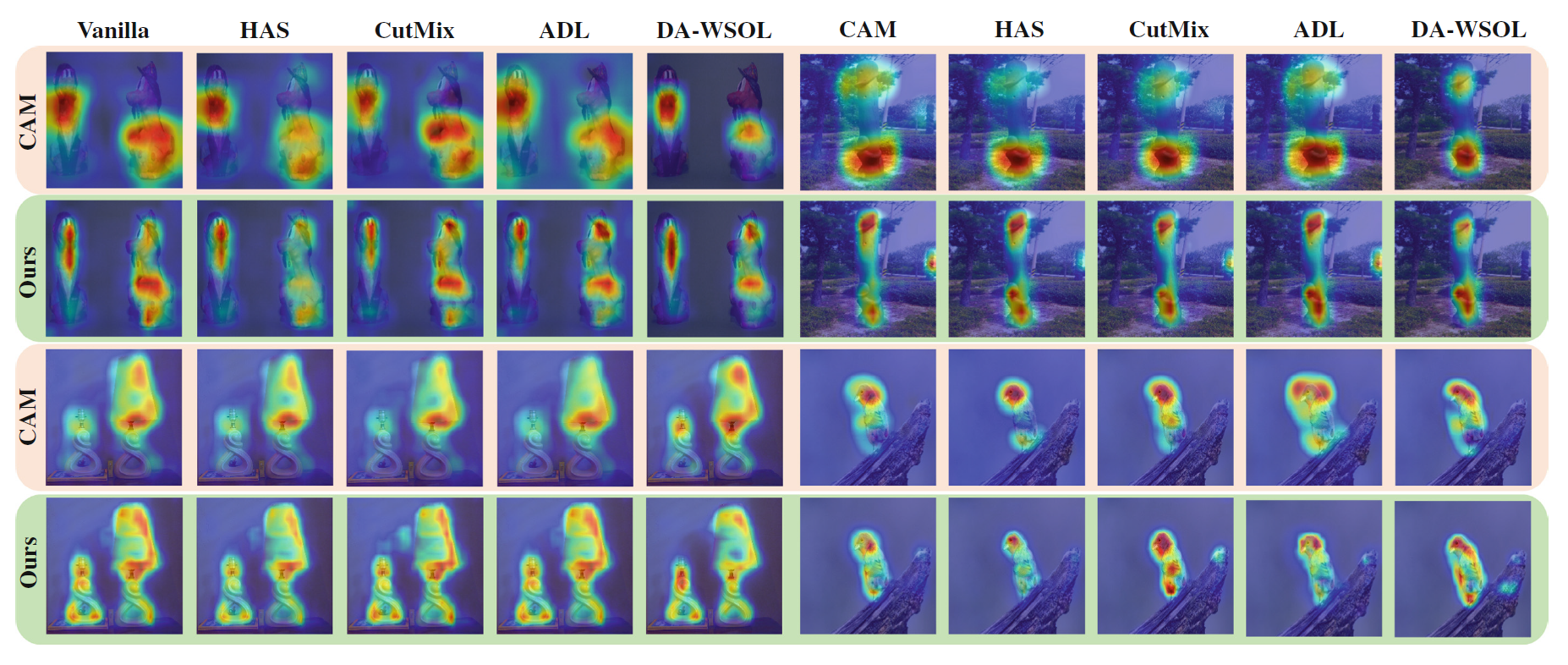

图3 常见WSOL方法中替换使用BagCAMs替换CAM的可视化结果

该论文的第一作者是MILab博士研究生朱磊,通讯作者是卢闫晔研究员。该研究得到了北京市自然科学基金重点项目(Z210008)和深圳科技计划(KQTD20180412181221912、JCYJ20200109140603831)的经费支持。

论文链接:https://doi.org/10.1007/978-3-031-20080-9_11

代码已开源:https://github.com/zh460045050/BagCAMs

添加评论