近期,MILab在图像去噪研究方面取得新进展,相关研究论文“One-Pot Multi-Frame Denoising”已被计算机视觉领域权威会议——2022年度不列颠机器视觉会议(BMVC 2022)接收,并作为亮点(spotlight)工作在会上发表演讲。

有监督的图像去噪方法严重地依赖干净图像作为学习的标签,但现实场景中干净图像往往是难以获取的。而无监督方法的去噪效果往往显著差于有监督方法。因此考 虑利用多帧含噪图像进行去噪是一个中和的选择。然而现有的基于学习的多帧图像去噪方法缺乏对多帧图像中所包含的关联性的充分利用,难以真正有效地挖掘出多 帧图像背后隐藏的噪声模式,因此也就无法达到与有监督方法相当的去噪效果。

在此背景下,MILab研究团队提出了一种全新的用于多帧图像去噪的无监督学习策略——一锅式多帧去噪(one-pot multi-frame denoising, OPD)。与包括有监督去噪(Noise2Clean, N2C)和无监督去噪(Noise2Noise, N2N)在内的几乎所有传统学习算法所使用的成对学习的策略不同,OPD在 训练中同时考虑对应于同一视野的多帧图像,在参与学习的多帧图像中的任意两两之间等概率地构建互监督关系,这使得训练过程能够更充分地考虑多帧间的关联并 更深入地挖掘隐藏在数据中的噪声模式。考虑到可学习模型学习的本质是在由预定义的损失函数所约束的参数空间中以迭代的方式寻找最小值,研究团队分别从参与 迭代训练的数据对的重构和对损失约束的精细设计两个方向出发,提出了两种执行OPD策略的具体算法:随机配对(random coupling, OPD-RC)和疏离损失(alienation loss, OPD-AL)。

OPD-RC在每一个新的迭代开始之前将对应于同一视野的多帧图像简单地进行随机重排列,以在迭代的全过程中持续地重建训练数据集。这使得多帧含噪图像中 的每一帧在每次迭代中以相同的概率出现,并以相同概率作为样本输入或标签。这一设计可以极大地提高训练数据对和数据对内部角色间监督的多样性,同时无需任 何额外的时间和算力消耗。只要模型的训练经历了足够多次数的迭代,在统计学上就有充分的理由认为多帧图像得到了充分且均匀的使用,并在实际上建立起了多帧 之间的互监督关系。图1显示了OPD-RC的一般原理及其与N2C和N2N的原理比较。

图1 OPD-RC与N2C和N2N的工作流程及原理差异对比示意图。图中下半部分的三个子图详细展示了三种监督策略的数据分配流程

图1 OPD-RC与N2C和N2N的工作流程及原理差异对比示意图。图中下半部分的三个子图详细展示了三种监督策略的数据分配流程

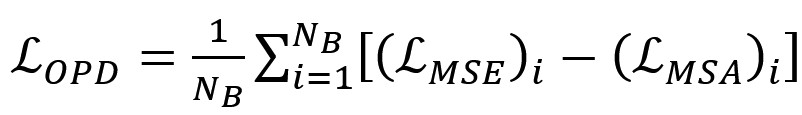

OPD-AL基于多帧平均最优化假设通过多项式定理的形式变换来设计OPD损失。损失函数包含均方误差损失和均方疏离差损失两部分,其中被用来计算去噪前后的图像差异,则被用来惩罚对不同帧去噪后结果之间的疏离。具体地:

其中,

其中表示批大小(batch size),表示对应于同一视野的图像帧数,为用于去噪的网络模型。

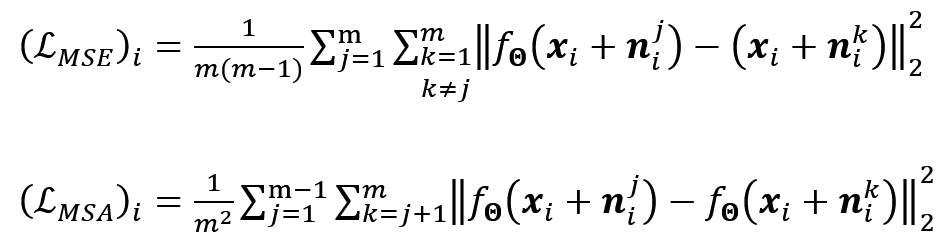

图2 合成高斯噪声和泊松噪声去噪的示例结果

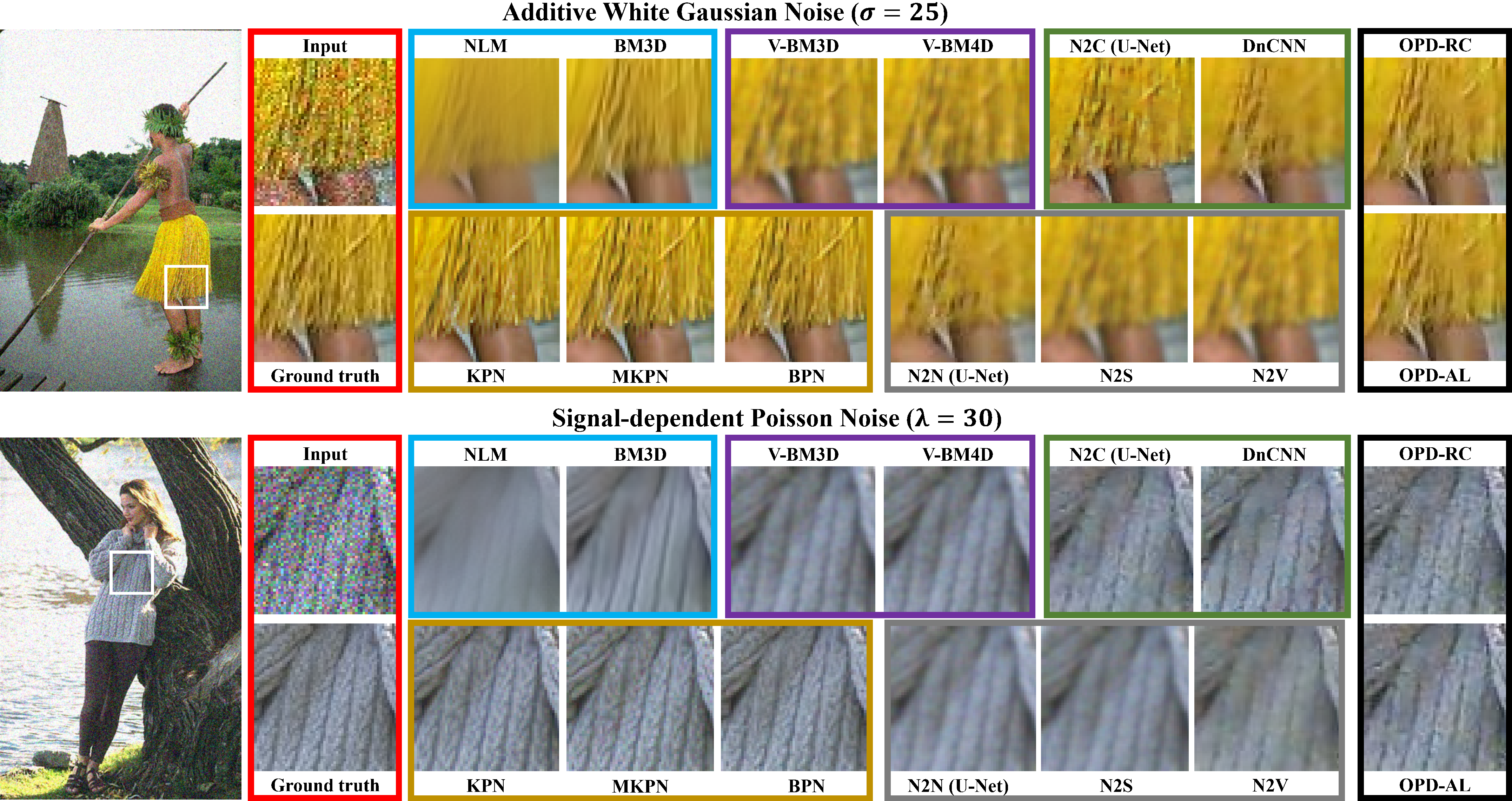

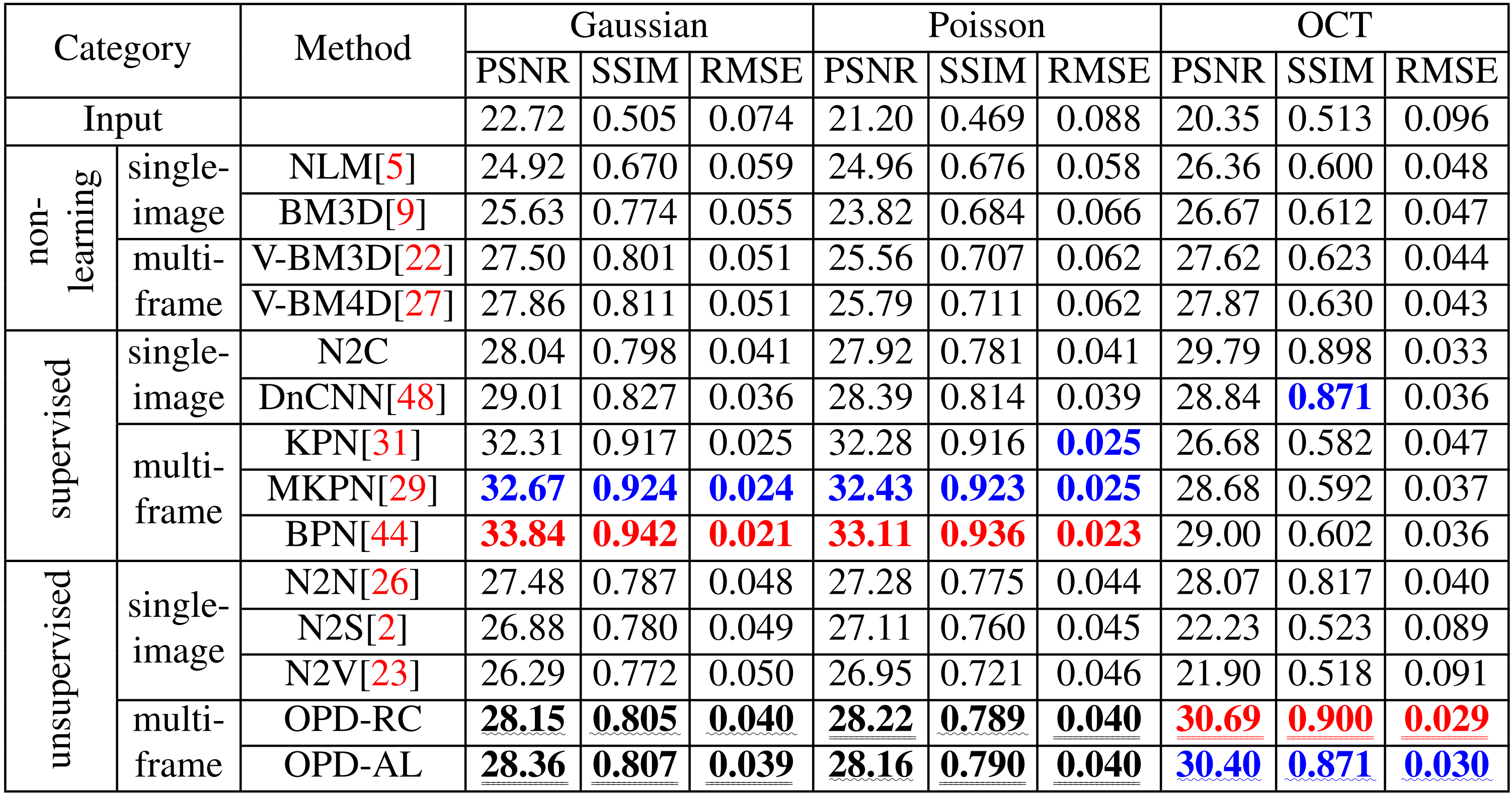

研究团队分别在合成噪声去噪和光学相干层析成像(optical coherence tomography, OCT)散斑噪声去噪两种任务上验证了OPD策略的有效性。理论上OPD策略可以用于任意针对图像去噪任务的深度学习模型,此处仅选用最经典的U-Net作为示范。在加性高斯白噪声和信号相关泊松噪声上的去噪结果示例见图2,在OCT散斑噪声上的去噪结果示例见图3,,量化结果见表1。从表1可以看出,无论是视觉效果还是量化指标,OPD策略均在所有的无监督方法中达到了最优。对高斯噪声,与N2N相比,OPD-AL的PSNR提升了0.88dB、SSIM提升了0.020并且RMSE下降了0.009。类似的提升也发生在OPD-RC上。指标上小的提升带来的是图像视觉效果大的改善,从图2可以看出OPD能够在去噪的同时更好地保留图像中的高频细节,比如上图中草裙边缘的穗带以及下图中毛衣上的花纹。而对OCT散斑噪声,OPD更是惊人地在包含监督学习算法的所有方法中达到了最优,并且去噪后的图像在视觉效果上堪与标签图像媲美。这提示了在包括OCT在内的诸多医学图像模态上,OPD可能发挥较强的去噪效果。

表1 合成噪声和OCT散斑噪声去噪的定量评估结果。其中最优和次优结果分别用红色和蓝色标出

图3 OCT散斑噪声去噪的示例结果

图3 OCT散斑噪声去噪的示例结果

上述实验表明,与同领域的诸多无监督方法相比,OPD策略无论是在定量指标上,还是在视觉效果上,均表现出显著的去噪性能提升。OPD在对噪声进行去除的同时,更好地保留了图像信息中的结构细节。在OCT上,OPD尤其具有可喜的表现。

该论文的第一作者是MILab博士研究生金录嘉,通讯作者是卢闫晔研究员。其他合作者还包括北京大学物理学院本科生赵时、MILab博士生朱磊和陈倩。该研究得到了北京市自然科学基金重点项目(Z210008)和深圳科技计划(KQTD20180412181221912、JCYJ20200109140603831)的经费支持。

论文链接:https://bmvc2022.mpi-inf.mpg.de/61/

代码将适时开源。

添加评论