近期,MILab在图像复原网络架构设计上取得进展,提出了一种基于平移等变性的图像复原网络新架构 ,相关研究论文“Enhancing Image Restoration Transformer via Adaptive Translation Equivariance”已被ICCV 2025会议接收。这篇文章介绍并分析了平移等变性在图像复原任务中的重要性,并基于此特性增强现有的图像复原网络的性能与计算效率。

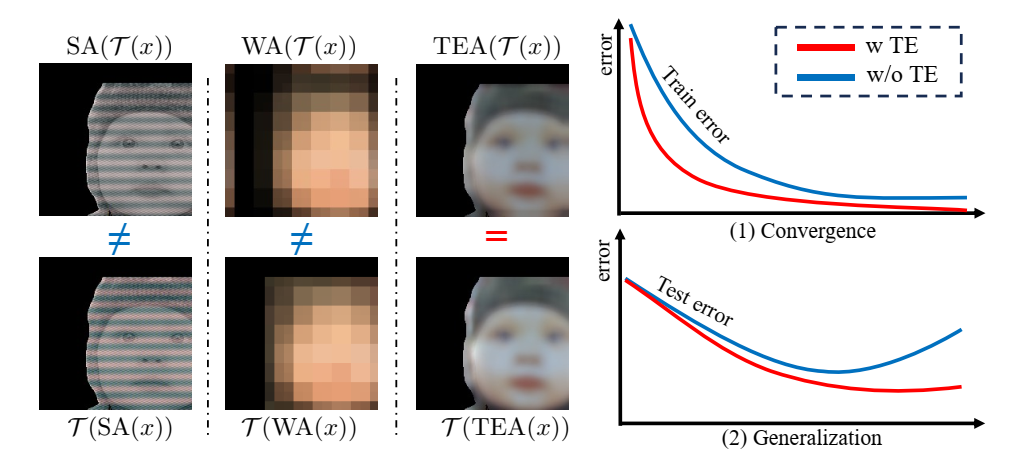

我们在该工作首先分析了平移等变性这一图像处理、计算摄影中常见的物理特性在图像复原任务中的重要性,如下图与下表所示:

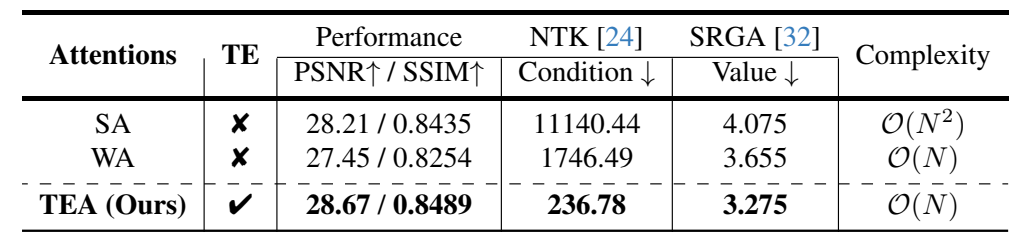

在 4 倍图像超分辨率任务中,我们考察了各种注意力机制的复原性能性能、理论收敛速度(由NTK条件数描述)、泛化能力(由SRGA指标描述)以及计算复杂度。以 SwinIR 作为基础模型,用原始自注意力机制和我们提出的 Translation Equivariance Adaptive (TEA) Attention 注意力机制替换 SwinIR 中的窗口注意力来进行这项预研究。在 Urban100 数据集上的实验结果表明,我们的 TEA 表现出快速收敛、增强的泛化能力和线性复杂度。

具体地,我们提出的 TEA 注意力机制的结构可见下图:

具体地,TEA从原始自注意力出发,引入了三大关键的架构改进:

- 变换原始自注意力机制中的键值对索引机制,从全局索引改变为滑动索引;

- 为滑动索引引入自适应窗口内外信息交互机制,以解决滑动索引带来的局限的感受野;

- 引入降采样自注意力,为模型提供粗略但全局的信息处理能力。

大量的实验结果表明该注意力机制在众多图像复原任务中优于以往的注意力机制。

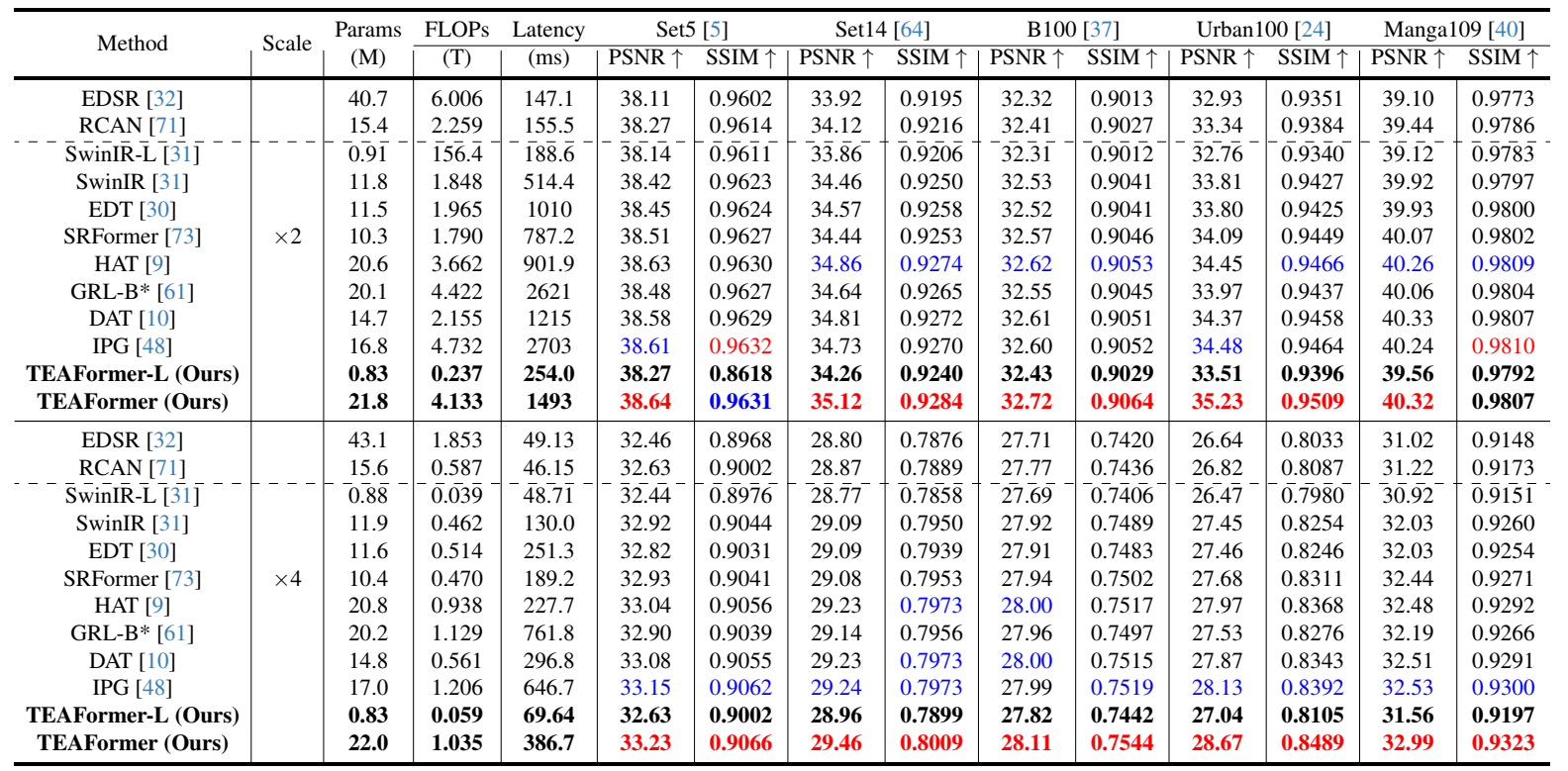

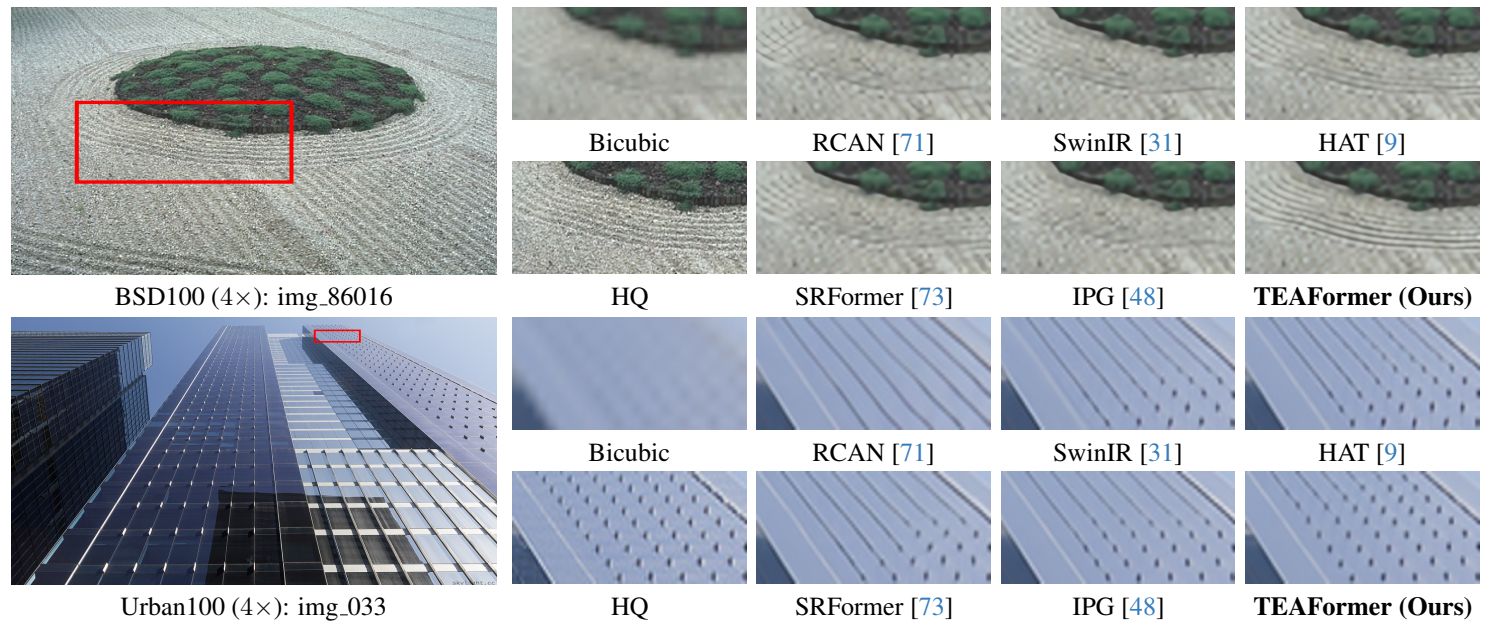

上表显示了图像超分辨率方法的定量比较。TEAFormer 的卓越性能显而易见,它在几乎所有五个数据集上都取得了各种尺度因子的最高结果。结合注意模块和翻译等价性,为恢复模型引入了更合适、更高效的归纳偏差,从而提升了其性能。对于4倍图像超分辨率任务,我们的 TEAFormer 在 Urban100 数据集上获得了28.67 dB的峰值信噪比(PSNR)分数,比 HAT 高出 0.7 dB,而两者都有 20 M 参数。与先前的图像SR方法 IPG 相比,TEAFormer在相当的FLOPs和2倍推理速度下,性能提升了 0.54 dB。一些感知比较结果如下:TEAFormer能复原出更精细的纹理。

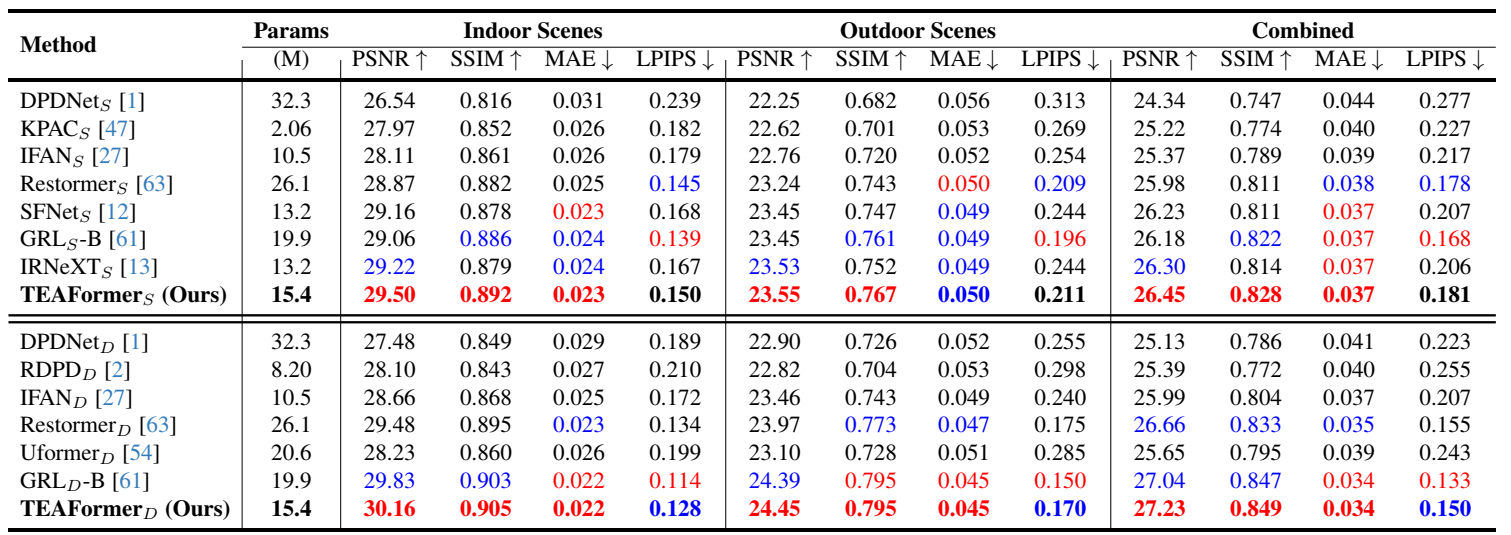

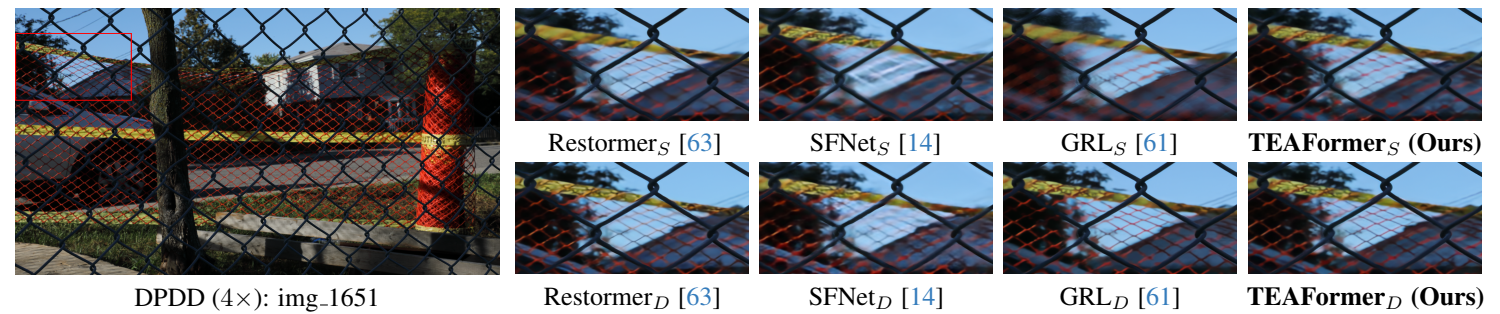

TEAFormer在单图像和双像素散焦去模糊任务上,在PSNR和SSIM指标上均显著优于最先进的方案。尤其是在单像素室内场景分类中,TEAFormer 比之前的最佳 Transformer 方法 GRL 提升了 0.44 dB。

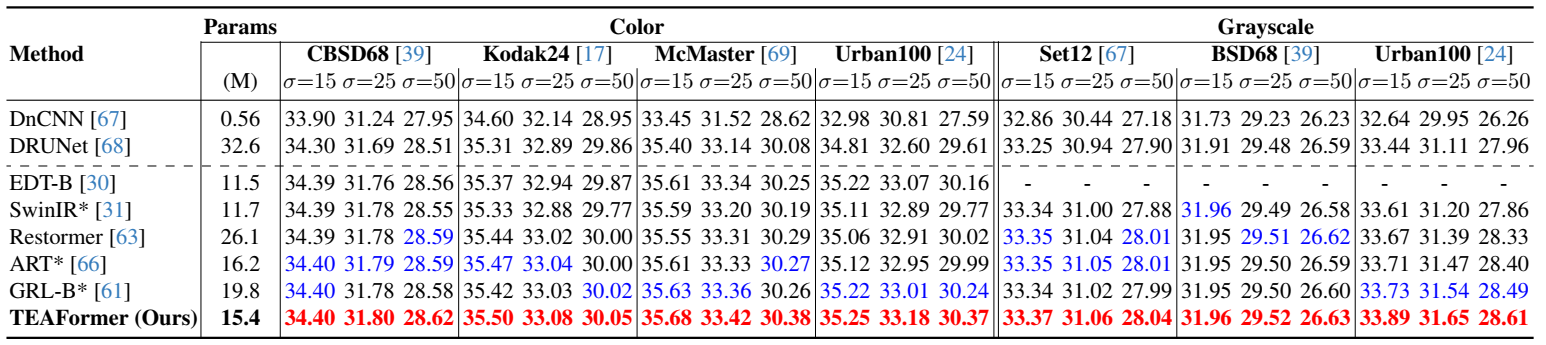

我们的 TEAFormer 在不同数据集和噪声水平的实验设置下均达到了最佳性能。具体而言,在彩色 Urban100 数据集上,对于噪声水平为 50 这一极具挑战性的任务,TEAFormer 比之前的最佳Transformer方法 GRL 提升了 0.13 dB。

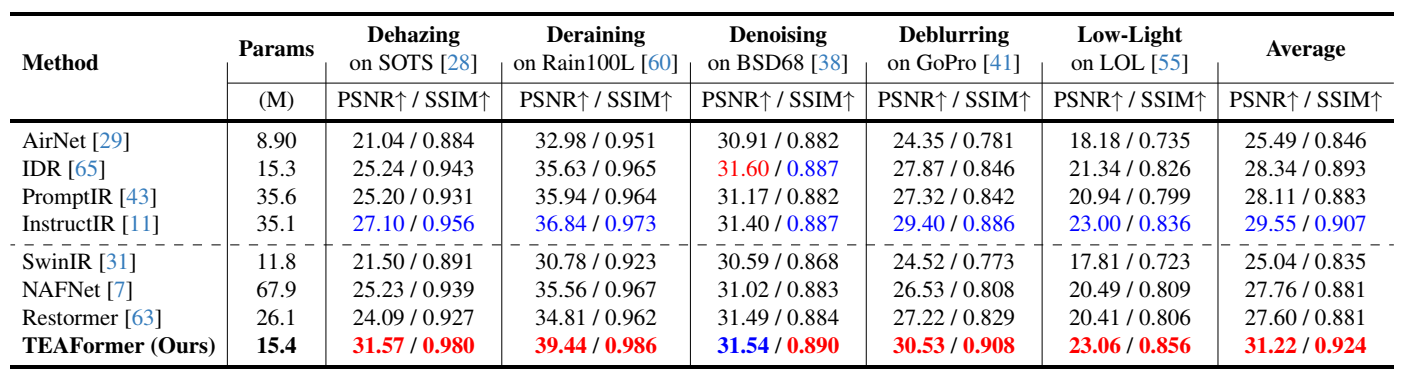

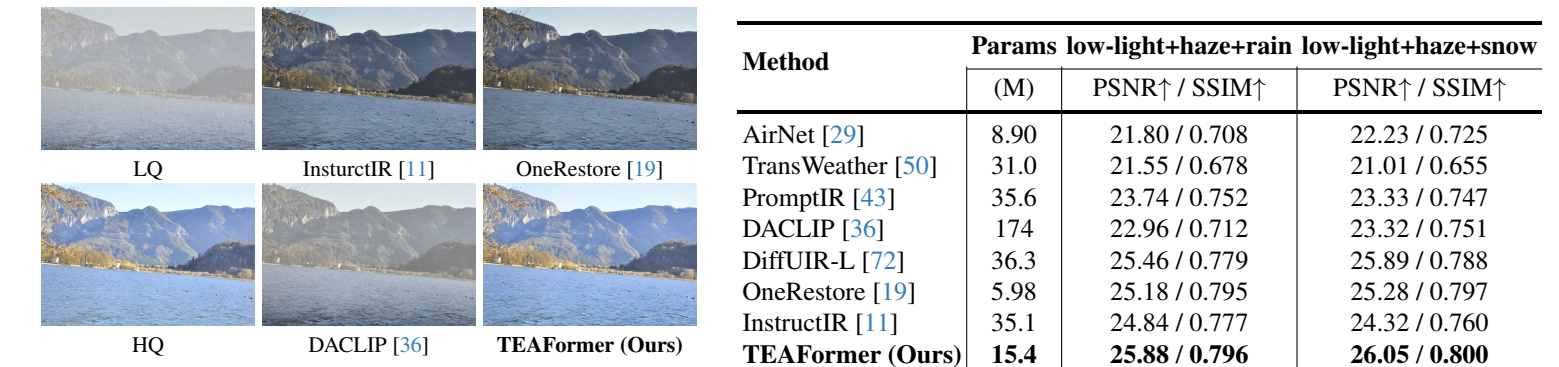

TEAFormer 的性能超越了最近提出的专为一体化综合修复任务设计的方法(如:IDR、PromptIR和InstructIR)。 TEAFormer 在五项任务中的平均 PSNR 均达到 31.22 dB,比目前最先进的 5D 一体化复原方法 InstructIR 高出 1.67 dB。TEAFormer 在每项任务的所有指标上均持续优于之前的 PSNR,彰显其在复杂多任务条件下图像复原的卓越能力。对于混合退化,TEAFormer 的表现优于最新提出的专为通用复原任务设计的方法(DiffUIR、OneRestore)。在三种退化(低光、雾霾和雨天)组合的场景下,TEAFormer 的性能优于目前最先进的通用复原方法 DiffUIR 高出 0.42 dB。

该论文第一作者为MILab博士生胡珈魁,卢闫晔助理教授为本文的通讯作者。其他合作者还包括MILab博士生姚政见和何航舟。该研究得到了国家自然科学基金、北京大学“临床+X”青年专项、北京大学肿瘤医院学科交叉专项资金的支持。

文章链接:Arxiv

添加评论